データが外に漏れないことを前提に、あなたやあなたのチームだけが使える安全で高性能なAIアシスタントを作ってみませんか?

自分専用のAIを構築して、業務の効率化や学習支援に活用できる方法をご紹介します!

この文章は、Google Cloud、Ollama、DeepSeek、Docker、Open WebUIを使って、自分だけのプライベートAIアシスタントを作る方法をわかりやすく説明します!

データが外に漏れないことを前提に、あなたやあなたのチームだけが使える安全で高性能なAIアシスタントを作ってみませんか?

自分専用のAIを構築して、業務の効率化や学習支援に活用できる方法をご紹介します!

この文章は、Google Cloud、Ollama、DeepSeek、Docker、Open WebUIを使って、自分だけのプライベートAIアシスタントを作る方法をわかりやすく説明します!

🔧 Step1: サーバーを準備しよう

- Google Cloud にアクセスしよう。

- 「Compute Engine」でサーバーを購入。メモリは16GB以上、OSはUbuntuがおすすめ!Storageは50GB。

🖥️ 必要なハードウェアについて

- CPU: 2コア以上

- AIモデルをスムーズに動かすには、複雑な処理を同時に行うために複数のコアが必要です。

- メモリ: 16GB以上(推奨)

- DeepSeekのような大規模なAIモデルを実行するには、十分なメモリが必要です。特に7Bや70Bモデルでは多くのデータを一時的に保持するため、16GB以上が推奨されます。

- ストレージ: 50GB以上

- モデルのダウンロードやアプリケーションのインストールには十分なディスク容量が必要です。特に複数のモデルを使用する場合、より多くのストレージが役立ちます。

- ファイアウォールを設定。

- ファイアウォールの役割: ファイアウォールは、サーバーへの不正アクセスを防ぐためのセキュリティ機能です。必要なポートだけを開放し、他のアクセスを遮断することで、サーバーを安全に保ちます。

- 設定内容:

- 目的: ネットワーク内の全てのサーバー

- 元のIPv4範囲: 0.0.0.0/0(どこからでも接続可能にする場合)

- TCPポート: 1000-20000(特定のアプリケーションが使用する範囲を開放)

🌟 Step2: OllamaとDeepSeekをインストールしよう

なぜOllamaとDeepSeekをセットで選ぶのか?

Ollamaは、AIモデルを簡単に管理・実行できるプラットフォームで、DeepSeekのような高性能な言語モデルを効率的に動かすために最適な環境を提供します。DeepSeekは複雑な質問にも正確な回答を生成できる強力なAIモデルで、Ollamaを使うことでインストールや運用が簡単になり、誰でも手軽にAIの力を活用できるようになります。 この組み合わせを選ぶ理由は以下の通りです:- 簡単なインストール: OllamaはワンコマンドでDeepSeekをセットアップできるため、初心者でも手軽に始められます。

- データの安全性: Ollamaはローカル環境で動作するため、やり取りするデータが外部に漏れる心配がありません。

- 高性能: DeepSeekは複数の推論を重ねてより正確な回答を導き出す「反省チェーン」機能を搭載しており、Ollamaの環境でその力を最大限に発揮できます。

📦 Step3: Dockerをインストールしよう

なぜDockerが必要なのか?

Dockerは、アプリケーションを「コンテナ」と呼ばれる環境にまとめて管理できるツールです。Open WebUIをセットアップする際、Dockerを使用することで複雑な設定を簡単に済ませ、安定して動作させることができます。 特に、Open WebUIはDockerコンテナ上で動作することを前提に設計されています。Dockerを使うことで、DeepSeekとOllamaをWebブラウザ上で操作できるようになり、より直感的にAIアシスタントを利用できるようになります。 Docker とは、アプリを簡単に管理できるツールです!下のコマンドを実行してインストールしましょう。💻 Step4: Open WebUIをインストールしよう

なぜOpen WebUIを選ぶのか?

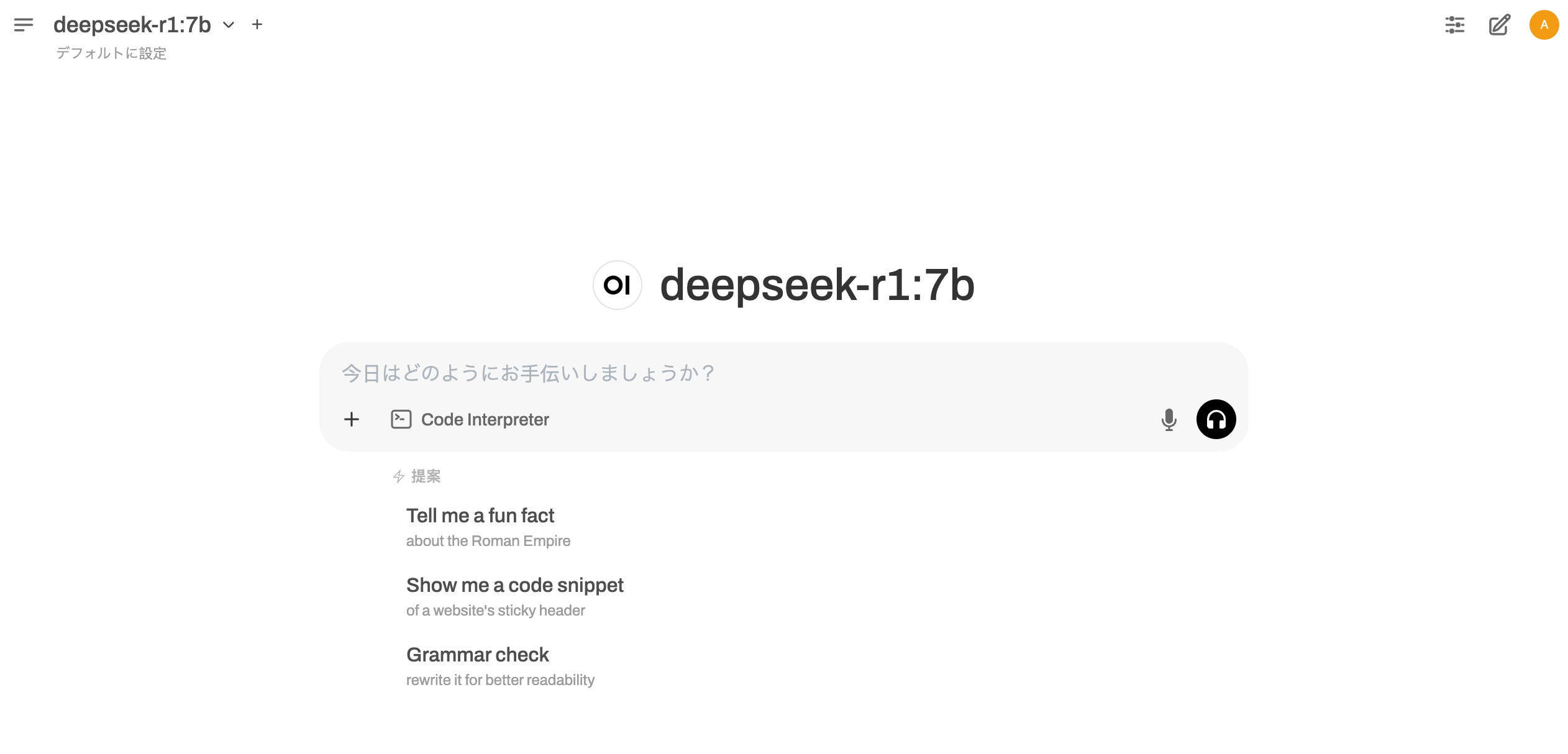

Open WebUIは、DeepSeekをより直感的に操作できるWebインターフェースを提供するプラットフォームです。これにより、ターミナル操作を必要とせず、ブラウザ上でAIとの対話を簡単に行えるようになります。 Open WebUIを使うメリット:- 使いやすいインターフェース: ブラウザから簡単にAIと対話可能。

- データの安全性: ローカル環境内で完結するため、プライバシーを保護。

- 多機能: 画像認識、ファイル分析、音声チャットなどを1つのプラットフォームで管理。

- Dockerのステータスを確認:

- Dockerが動いていない場合は起動:

- 再度Dockerコマンドを実行。

🌐 Step5: ファイアウォール設定とアクセス確認

外部からアクセスできない場合は、サーバーのファイアウォール設定を確認しましょう。 1. UFW(Ubuntuのファイアウォール)を有効化:- GCPコンソール > VPCネットワーク > ファイアウォールルール に移動。

- 新しいルールを作成:

- 名前: allow-open-webui

- ターゲット: ネットワーク内のすべてのインスタンス

- ソースIP範囲: 0.0.0.0/0

- プロトコルとポート: TCP:3000