DeepSeek 作为具备多轮推理能力的开源大语言模型,以高性能、低成本、易部署的特性成为智能应用开发的理想基座。它的先进算法架构和”反思链”能力,让 AI 对话交互效果几乎已经追平 OpenAI 旗下的 o1 模型。更关键的是,它是开源的,每个人都可以拥有更智能与自然的 AI 大模型!

这意味着你完全可以在自己的服务器环境上部署 DeepSeek 服务,在对话过程中无惧隐私泄露的风险,你的数据你说了算。对于有进一步开发能力的用户,你还可以为它添加文件分析(RAG 功能)、在线搜索以及工具使用能力。

本文将为你完整介绍如何在 Google Cloud 购买服务器、DeepSeek 服务、部署 LM Studio 软件,帮助你快速搭建出专属的 AI 助手。

DeepSeek 作为具备多轮推理能力的开源大语言模型,以高性能、低成本、易部署的特性成为智能应用开发的理想基座。它的先进算法架构和”反思链”能力,让 AI 对话交互效果几乎已经追平 OpenAI 旗下的 o1 模型。更关键的是,它是开源的,每个人都可以拥有更智能与自然的 AI 大模型!

这意味着你完全可以在自己的服务器环境上部署 DeepSeek 服务,在对话过程中无惧隐私泄露的风险,你的数据你说了算。对于有进一步开发能力的用户,你还可以为它添加文件分析(RAG 功能)、在线搜索以及工具使用能力。

本文将为你完整介绍如何在 Google Cloud 购买服务器、DeepSeek 服务、部署 LM Studio 软件,帮助你快速搭建出专属的 AI 助手。

前置准备

- VPS / GPU Server

- CPU >= 2 Core

- 显存/RAM ≥ 16 GiB(推荐)

- Docker

- Ollama

1. 购买服务器资源

访问 GCP,选择 Compute Engine 服务。 选择内存 ≥ 16GB 的服务器配置。建议安装 Ubuntu 操作系统。 为了避免在后续安装应用时可能面临的访问异常,建议打开服务器的防火墙。轻点 “VPC 网络” → 防火墙 → “添加防火墙规则”。- 目标:网络中的所有实例

- 来源 IPv4 范围,填写 0.0.0.0/0

- 协议和端口,选择 TCP 连接,端口范围填写 1000-20000。端口是服务器中常见的一个概念,ollama 将默认占用 11434 端口的服务,后续将 AI 应用分享给他人时,需确保端口可以被公网访问。

2. 安装 Docker 以及 Ollama

Docker 是一个便捷的容器拉取平台,你可以将它理解为 Linux 服务器中的 App Store,它会帮助我们非常便捷的管理需要下载的软件和应用程序。安装命令:ollama -v 命令确认是否安装成功。(如果成功将会输出版本号)

3. 安装 DeepSeek

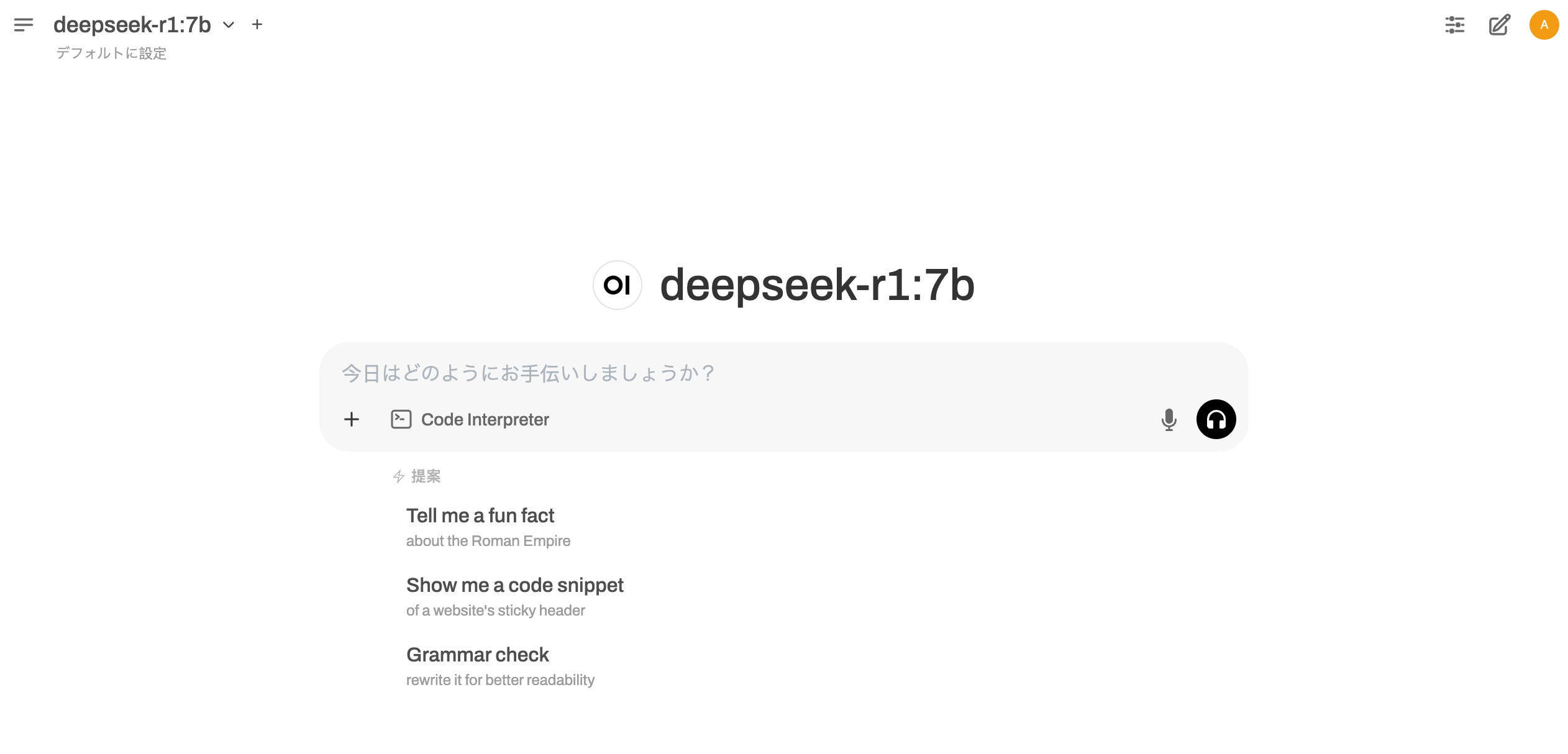

根据实际的环境配置,选择合适的 DeepSeek 尺寸模型进行部署。 运行模型很简单,确定好想要的模型后,复制对应的命令到你的终端并执行。 根据需求,使用以下命令下载不同型号的 DeepSeek-R1 模型: DeepSeek-R1-Distill-Qwen-1.5B4. 安装用户界面 — Open WebUI

Open WebUI 是一个可扩展、功能丰富、用户友好的私有部署 AI 平台,它无缝支持各种 AI 大模型,并内置 RAG 推理引擎,这意味着它可以调用私有 AI 模型帮助你分析文件,是一个强大的人工智能部署解决方案。 当你已在服务器上部署 ollama 时,可以使用以下命令安装 Open WebUI,它将自动建立与 Ollama 服务器的连接,无需额外复杂的配置。http://your_server_ip:3050/ 即可进入 WebUI 的初始化页面,稍等片刻后,按照提示输入用户名、邮箱和密码完成初始化。

Bingo,你得到了你的专属私人 AI 助手,并且内置图片识别助手、文件分析功能、语音聊天等基础功能。接下来你可以自己多多尝试,自由探索 AI 时代下的互联网应用!

如果你想要将 IP 与域名绑定,把它变成自己的服务,亦或是需要寻求本地部署支持,欢迎点击网页上的联系按钮,我们将为你提供付费支持。